🗣 SL提问: ai问答制作

✍️ Ai批改: 制作一个AI问答系统需要考虑多个方面,包括技术选型、数据准备、模型训练和部署等。以下是一个基本的步骤指南:

1、确定需求和技术选型

需求分析:明确你的问答系统的应用场景和目标用户。例如,是用于客服支持、教育辅导还是其他领域。

技术选型:

语言模型:可以选择使用现有的预训练语言模型,如BERT、RoBERTa、T5等,或者自己训练模型。

框架选择:常用的深度学习框架有TensorFlow、PyTorch等。

2、数据准备

收集数据:根据你的应用场景,收集相关领域的问答数据。可以是从公开的数据集(如SQuAD、TriviaQA等)中获取,也可以通过爬虫抓取相关网站的数据。

数据清洗:对收集到的数据进行清洗,去除噪声和不相关的数据。

标注数据:如果需要,对数据进行标注,以便用于模型训练。

3、模型训练

预处理数据:将文本数据转换为模型可以理解的格式,通常包括分词、向量化等。

训练模型:

python

import torch

from transformers import BertTokenizer, BertForQuestionAnswering

加载预训练模型和分词器

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForQuestionAnswering.from_pretrained('bert-base-uncased')

示例输入

question = What is the capital of France?

text = Paris is the capital of France.

编码输入

inputs = tokenizer.encode_plus(question, text, return_tensors='pt')

获取输出

outputs = model(inputs)

answer_start = torch.argmax(outputs.start_logits) 获取开始位置

answer_end = torch.argmax(outputs.end_logits) + 1 获取结束位置

解码答案

answer = tokenizer.convert_tokens_to_string(tokenizer.convert_ids_to_tokens(inputs['input_ids'][0][answer_start:answer_end]))

print(fAnswer: {answer})

4、模型优化

调参:调整模型的超参数以提高性能。

微调:在特定领域上微调预训练模型。

5、部署

选择平台:可以选择云服务提供商(如AWS、Azure、Google Cloud)或自建服务器。

API接口:创建API接口以便前端应用调用。

监控和维护:定期监控模型的表现,并根据反馈进行调整和更新。

6、测试和评估

测试:在真实环境中测试模型的性能。

评估指标:使用准确率、召回率、F1分数等指标评估模型表现。

7、用户界面

前端开发:设计和开发用户界面,使用户能够方便地输入问题并查看答案。

交互设计:确保用户体验流畅,响应迅速。

示例代码

以下是一个简单的Flask应用示例,用于部署问答系统:

python

from flask import Flask, request, jsonify

import torch

from transformers import BertTokenizer, BertForQuestionAnswering

app = Flask(__name__)

加载预训练模型和分词器

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForQuestionAnswering.from_pretrained('bert-base-uncased')

@app.route('/answer', methods=['POST'])

def get_answer():

data = request.get_json()

question = data['question']

text = data['text']

编码输入

inputs = tokenizer.encode_plus(question, text, return_tensors='pt')

获取输出

outputs = model(inputs)

answer_start = torch.argmax(outputs.start_logits) 获取开始位置

answer_end = torch.argmax(outputs.end_logits) + 1 获取结束位置

解码答案

answer = tokenizer.convert_tokens_to_string(tokenizer.convert_ids_to_tokens(inputs['input_ids'][0][answer_start:answer_end]))

return jsonify({'answer': answer})

if __name__ == '__main__':

app.run(debug=True)

这个简单的Flask应用可以通过POST请求接收问题和文本,返回模型生成的答案。

希望这些信息对你有所帮助!如果你有任何具体的问题或需要进一步的帮助,请随时告诉我。

0

IP地址: 124.153.141.247

搜索次数: 14

提问时间: 2025-04-20 17:47:14

❓️ 热门提问:

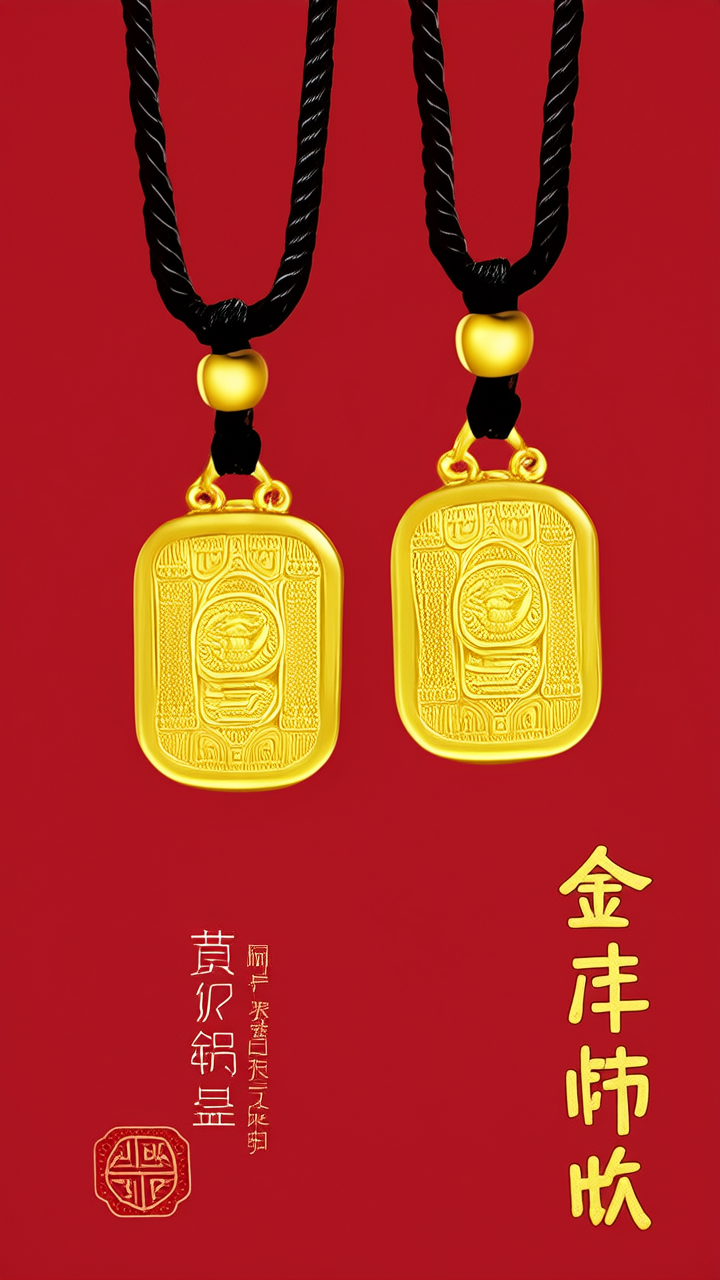

100克黄金链子

外贸公司建站价格

信澳产业优选一年持有混合C

gold class厅

30克金条能卖多少钱

.grp.lk域名

步行街哪里回收黄金

ai 照片清晰

ai模糊怎么做

ai解答问题

豌豆Ai站群搜索引擎系统

🤝 关于我们:

三乐Ai

作文批改

英语分析

在线翻译

拍照识图

Ai提问

英语培训

本站流量

联系我们

📢 温馨提示:本站所有问答由Ai自动创作,内容仅供参考,若有误差请用“联系”里面信息通知我们人工修改或删除。

👉 技术支持:本站由豌豆Ai提供技术支持,使用的最新版:《豌豆Ai站群搜索引擎系统 V.25.05.20》搭建本站。